Plongez dans la symphonie thermique où data centers éco‑responsables et casinos en ligne dansent avec efficacité énergétique. Découvrez comment latence nulle et refroidissement liquide fusionnent pour un numérique durable. En savoir plus.

Infrastructures vertes et plateformes de divertissement : synergie technique et performance

L’optimisation des flux thermiques dans un centre de données moderne ne se résume pas simplement à réduire la facture d’électricité, c’est une question de survie opérationnelle pour les industries à haute disponibilité. Les experts en infrastructure IT s’accordent à dire que la gestion de la charge serveur pour des applications en temps réel nécessite une précision chirurgicale, surtout lorsque l’on considère l’empreinte carbone colossale du numérique.

C’est ici que deux mondes apparemment distincts se heurtent : la rigueur de l’ingénierie des Green Data Centers et l’exubérance du divertissement numérique. L’utilisateur final, qui lance une partie de jeu de casino sur son smartphone, n’imagine pas une seconde que la fluidité de son expérience dépend directement du PUE (Power Usage Effectiveness) d’une salle serveur située peut‑être à des milliers de kilomètres. Pourtant, la corrélation est absolue.

D’ailleurs, il est fascinant d’observer comment les exigences de latence quasi nulle des plateformes de jeux d’argent en ligne ont poussé les ingénieurs à repenser les systèmes de refroidissement passif. Les spécialistes notent que, pour maintenir une intégrité parfaite des générateurs de nombres aléatoires (RNG) sans surchauffe, l’architecture même des baies de stockage a dû évoluer. Ce n’est plus seulement une question de « sauver la planète », bien que ce soit noble, mais de garantir que le flux de données reste constant, sécurisé et énergétiquement viable. Cette transition vers le vert offre une stabilité que les anciens systèmes énergivores ne pouvaient tout simplement pas maintenir sur la durée.

La consommation énergétique invisible des transactions numériques à haute fréquence

Chaque rotation virtuelle, chaque distribution de carte et chaque transaction financière génère une demande computationnelle spécifique qui, multipliée par des millions d’utilisateurs, crée une charge thermique immédiate. Les ingénieurs le savent : le processeur ne fait pas de distinction morale entre un calcul scientifique et une machine à sous virtuelle, il chauffe, tout simplement.

Il faut être réaliste : la gestion de ces pics de charge est le cauchemar logistique de tout administrateur réseau. Traditionnellement, la réponse était d’ajouter plus de puissance brute, plus de climatisation mécanique, augmentant drastiquement le coût opérationnel et l’impact écologique. Cependant, l’approche moderne privilégie l’élasticité de l’infrastructure.

Les plateformes de jeux, qui fonctionnent 24 heures sur 24 et 7 jours sur 7, sont devenues, un peu par nécessité, des cas d’école pour l’implémentation de solutions d’hébergement éco‑responsables. Si l’on ne dissipe pas la chaleur efficacement, le matériel se dégrade, la latence augmente (le fameux « lag » que les joueurs détestent) et le ROI s’effondre.

Les infrastructures vieillissantes peinent à suivre. On observe souvent que les opérateurs de centres de données qui n’ont pas migré vers des solutions de free cooling ou de refroidissement liquide voient leurs marges se faire grignoter par les coûts énergétiques. C’est mathématique. Pour un site à fort trafic, l’adoption de serveurs à basse consommation pour les tâches de fond, couplée à des unités de haute performance uniquement sollicitées lors des pics, permet de lisser la courbe de consommation.

Parmi les aspects techniques majeurs, la virtualisation joue un rôle prépondérant. Au lieu de faire tourner des serveurs physiques à 15 % de leur capacité — un gaspillage énergétique aberrant — les conteneurs virtuels permettent de densifier l’usage. Pour l’industrie du jeu, cela signifie moins de matériel physique pour le même nombre de connexions simultanées. C’est une victoire pour l’ingénierie verte et pour la stabilité du service.

| Impact de l’optimisation verte sur la performance serveur | |||

|---|---|---|---|

| Paramètre technique | Infrastructure Classique (Legacy) | Infrastructure Verte Optimisée | Gain estimé pour l’opérateur |

| PUE (Efficacité Énergétique) | 2.0 – 2.5 | 1.1 – 1.2 | Réduction de 40-50% des coûts énergétiques |

| Densité de calcul | Faible (Beaucoup d’espace vide) | Haute (Virtualisation poussée) | Moins d’empreinte au sol |

| Refroidissement | Climatisation mécanique (CRAC) | Free Cooling / Immersion liquide | Stabilité thermique accrue |

| Durée de vie du matériel | 3-4 ans (Stress thermique) | 5-7 ans (Température stable) | Meilleur amortissement |

| Latence réseau | Variable selon la chauffe | Constante et prévisible | Expérience utilisateur (UX) supérieure |

| Source d’énergie | Mix réseau standard | Renouvelable / PPA (Power Purchase Agreement) | Conformité RSE et image de marque |

L’architecture serveur face aux exigences du temps réel

La latence est l’ennemi juré de toute interaction en ligne, mais dans le domaine des jeux d’argent ou du trading haute fréquence, quelques millisecondes peuvent changer l’issue d’une session. Les spécialistes réseaux travaillent d’arrache‑pied pour rapprocher le calcul de l’utilisateur. C’est là que l’Edge Computing entre en scène, une composante essentielle des infrastructures vertes modernes.

Plutôt que de faire voyager une donnée sur des milliers de kilomètres, traversant de multiples routeurs et commutateurs (chacun consommant de l’énergie), le traitement se fait en périphérie de réseau. Pour un joueur situé à Lyon, il est absurde que sa requête soit traitée à Las Vegas ou à Malte, puis renvoyée. L’Edge Computing permet de traiter l’action localement, réduisant la distance parcourue par l’information et, par corollaire, l’énergie nécessaire à son transport. C’est une logique implacable : moins de distance égale moins de consommation.

Les serveurs utilisés pour ces nœuds périphériques sont souvent de nouvelles générations, conçus spécifiquement pour une efficacité maximale par watt. On ne cherche plus la puissance brute absolue, mais le meilleur ratio performance/consommation. Les processeurs ARM, par exemple, commencent à se faire une place de choix dans ces architectures décentralisées, offrant des capacités de traitement suffisantes pour la gestion des sessions utilisateurs sans la gourmandise énergétique des architectures x86 traditionnelles.

Honnêtement, il y a dix ans, personne ne se souciait vraiment de savoir si le serveur qui hébergeait une table de blackjack virtuelle était alimenté par du charbon ou de l’éolien. Aujourd’hui, avec la pression réglementaire et le coût de l’énergie, c’est devenu une variable critique de l’équation économique. Les architectes système doivent désormais jongler entre disponibilité (SLA) et efficacité énergétique.

La redondance des données, nécessaire pour la sécurité et la conformité légale, est aussi repensée. Au lieu de copier les données sur trois disques durs mécaniques qui tournent en permanence, on utilise de plus en plus du stockage « froid » sur bande ou sur des disques qui se mettent en veille profonde, ne s’activant que lors des audits ou des récupérations après sinistre. C’est moins sexy que des SSD clignotants, mais c’est infiniment plus respectueux de l’environnement.

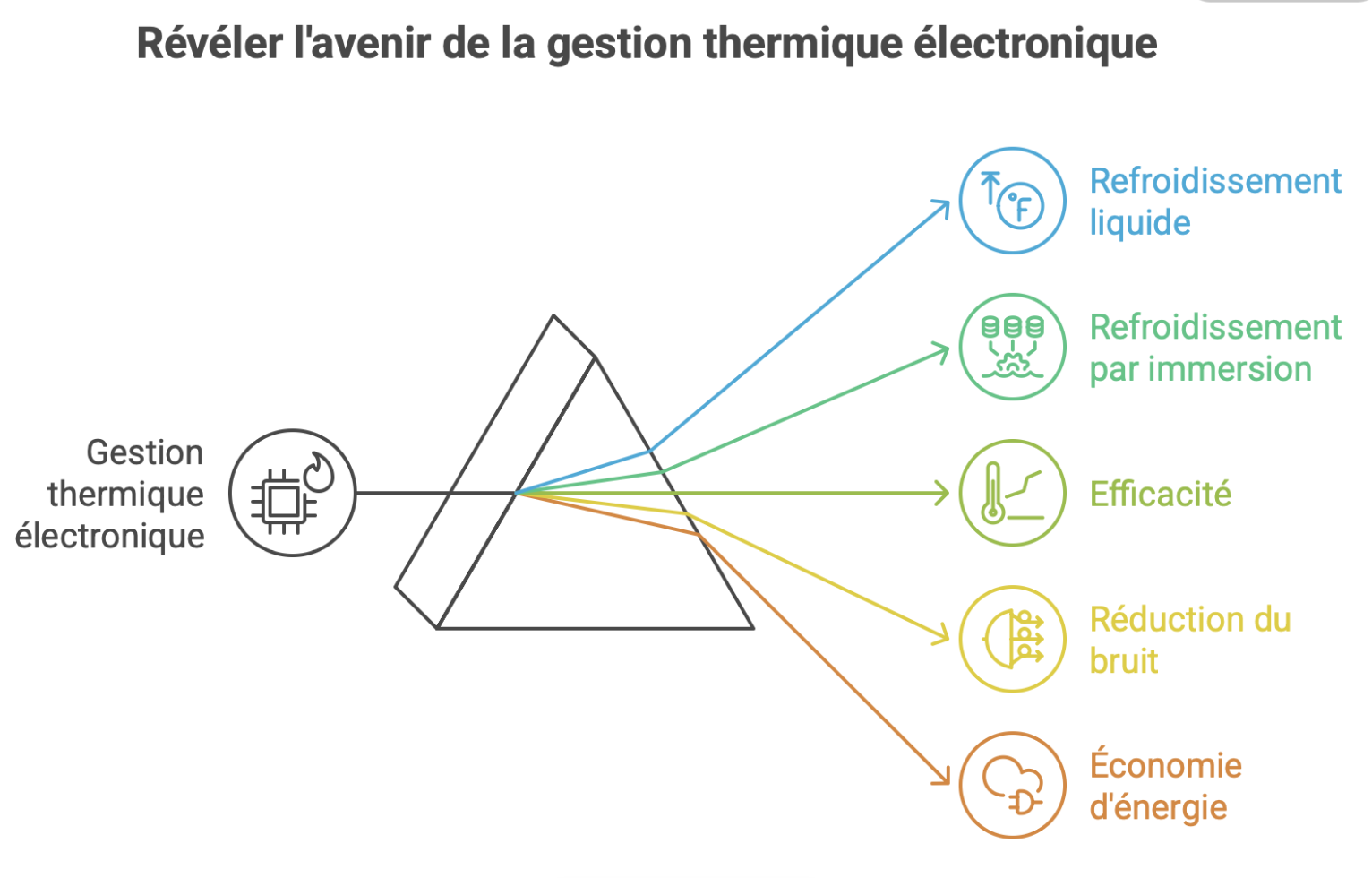

Le refroidissement liquide et l’immersion: solutions d’avenir

L’air est un piètre conducteur thermique, c’est une loi de la physique que l’on ne peut pas contourner, peu importe la puissance des ventilateurs. Les infrastructures hébergeant des services gourmands en ressources, comme le streaming vidéo en direct des casinos Live Dealer, génèrent une densité de chaleur que l’air peine à évacuer. L’immersion diphasique ou monophasique dans des fluides diélectriques s’impose comme la solution technique de référence.

Imaginez des serveurs entiers plongés dans un liquide qui ressemble à de l’eau mais qui ne conduit pas l’électricité. Ce fluide capture la chaleur directement à la source (le processeur, la mémoire, les VRM) avec une efficacité redoutable. Pour les plateformes qui doivent assurer un streaming vidéo 4K sans interruption, cela garantit que le matériel ne subit pas de throttling (baisse de fréquence due à la chaleur). Les collègues ingénieurs rapportent des réductions de la consommation liée au refroidissement allant jusqu’à 95 % par rapport à l’air climatisé traditionnel.

De plus, cette technique permet de récupérer les calories. La chaleur dégagée par les serveurs qui gèrent les parties de poker ou les machines à sous n’est plus rejetée inutilement dans l’atmosphère. Elle est capturée par le liquide, passée dans un échangeur thermique, et peut servir à chauffer des bureaux adjacents ou même rejoindre un réseau de chaleur urbain. On transforme un déchet (la chaleur fatale) en ressource.

Cependant, la mise en place de ces systèmes demande une expertise pointue. On ne plonge pas un rack de serveurs dans l’huile minérale sans préparation. Il faut vérifier la compatibilité des matériaux, des joints, des câbles. C’est un investissement initial lourd, mais le TCO (Total Cost of Ownership) sur cinq ans est souvent largement favorable, surtout dans un contexte de prix de l’énergie volatile.

Liste des avantages techniques du refroidissement liquide pour les serveurs haute densité :

- Stabilité thermique absolue éliminant les points chauds sur le PCB.

- Silence de fonctionnement quasi total (plus de ventilateurs hurlants).

- Protection contre l’oxydation, la poussière et l’humidité ambiante.

- Possibilité d’overclocker les composants pour plus de performance sans risque majeur.

- Densité de calcul multipliée par quatre ou cinq dans le même volume physique.

- Réduction drastique de la consommation électrique « inutile » (celle des ventilateurs).

- Maintenance simplifiée à long terme grâce à l’absence de filtres à air à changer.

- Possibilité d’implanter des data centers dans des zones géographiques chaudes sans surcoût excessif.

Sécurité des données et cryptographie éco‑efficiente

Le chiffrement est obligatoire, non négociable, mais il est aussi extrêmement coûteux en cycles CPU. Chaque bit de donnée échangé entre un joueur et la plateforme doit être sécurisé par des protocoles SSL/TLS robustes. Les algorithmes de cryptographie asymétrique nécessitent des calculs complexes qui, à l’échelle de millions de connexions, représentent une part significative de la consommation énergétique des serveurs.

Les spécialistes en cryptographie travaillent désormais sur des algorithmes « légers » qui offrent le même niveau de sécurité mais avec une complexité computationnelle moindre. L’objectif est de réduire la charge processeur nécessaire pour établir et maintenir une connexion sécurisée. Dans le contexte des infrastructures vertes, choisir le bon algorithme de chiffrement fait partie intégrante de la stratégie d’efficacité énergétique.

Il est aussi question de l’optimisation matérielle. Les processeurs modernes intègrent des jeux d’instructions spécifiques (comme AES‑NI) qui accélèrent le chiffrement matériellement plutôt que logiciel. Utiliser ces fonctionnalités natives réduit la consommation électrique par rapport à une exécution logicielle brute. Pour une plateforme de jeu qui gère des milliers de transactions financières par seconde, l’impact cumulé est massif.

En outre, la gestion des certificats et des clés de sécurité doit être centralisée et optimisée. Des modules de sécurité matérielle (HSM) de nouvelle génération sont conçus pour être moins énergivores tout en garantissant l’intégrité des clés. La confiance des utilisateurs repose sur cette sécurité, mais l’environnement bénéficie de son optimisation. C’est un équilibre délicat que les RSSI (Responsables de la Sécurité des Systèmes d’Information) doivent trouver.

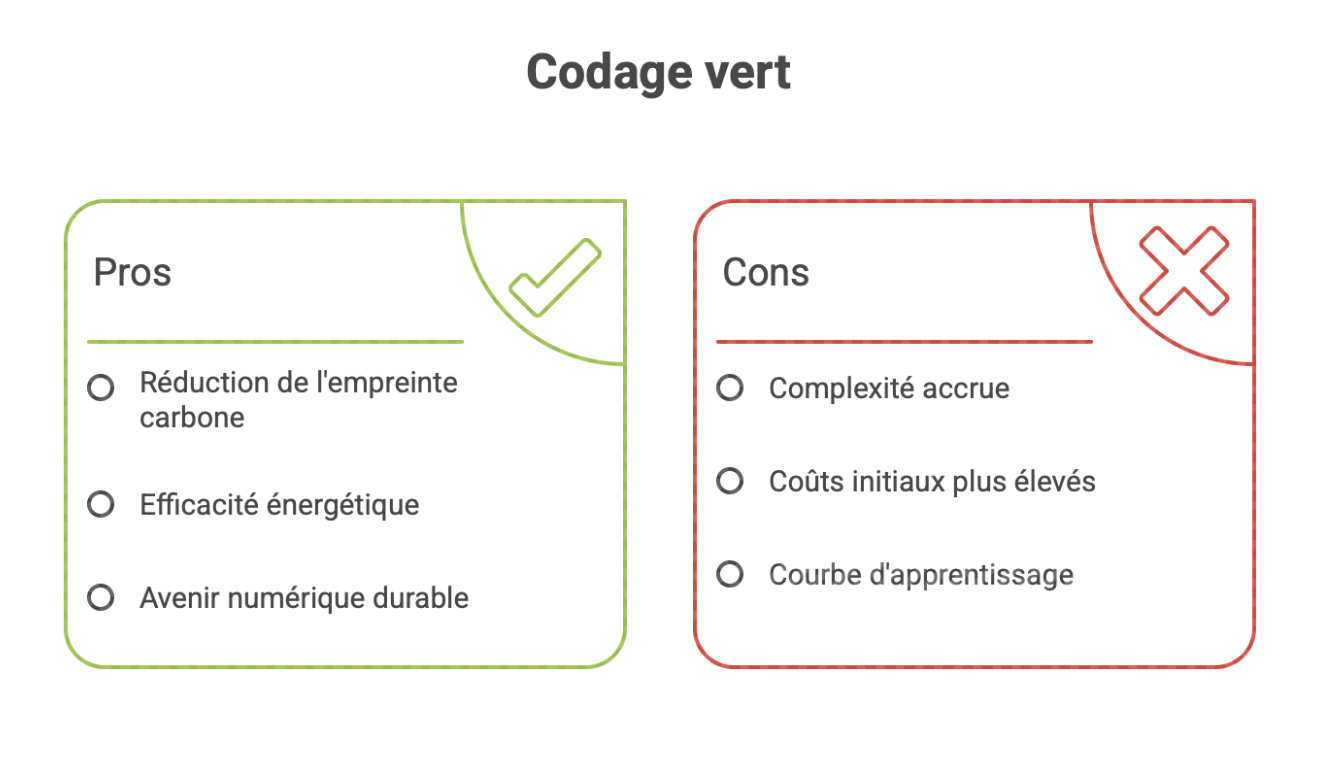

L’impact du code et l’avènement du Green Coding

Le matériel le plus efficace du monde ne servira à rien si le logiciel qui tourne dessus est mal écrit. On assiste à une prise de conscience brutale dans le milieu du développement : le code « sale », bouclé à la va‑vite, consomme de l’électricité. Un script mal optimisé qui tourne en boucle sur un serveur, c’est comme laisser la lumière allumée dans une pièce vide, indéfiniment.

Le Green Coding ou éco‑conception logicielle vise à produire des applications plus légères, plus rapides et moins gourmandes en ressources. Pour une application de jeu, cela signifie optimiser les assets graphiques pour qu’ils ne nécessitent pas un téléchargement massif à chaque connexion, minimiser les requêtes vers la base de données et nettoyer le code mort.

Prenons l’exemple des animations JavaScript sur une page d’accueil. Si elles sont mal codées, elles peuvent faire grimper l’utilisation du CPU du client (et donc sa consommation de batterie) à 100 %. Côté serveur, des requêtes SQL inefficaces peuvent forcer les disques et les processeurs à travailler dix fois plus que nécessaire pour extraire une simple information de solde utilisateur. Les développeurs seniors passent désormais beaucoup de temps à refactoriser le code existant pour le rendre plus « frugal ».

D’un point de vue purement pragmatique, un code optimisé charge plus vite. Et l’on sait pertinemment que la vitesse de chargement est un facteur clé de conversion et de rétention. L’écologie rejoint ici l’intérêt économique direct. Moins de ressources serveur consommées signifie aussi des factures d’hébergement cloud (AWS, Azure, Google Cloud) moins salées à la fin du mois.

Les langages compilés comme Rust ou Go gagnent du terrain face aux langages interprétés plus lourds (comme Python ou Ruby) pour les services backend critiques, justement à cause de leur efficacité énergétique supérieure. Chaque watt économisé par ligne de code compte lorsque l’échelle est mondiale.

La gestion des données massives et le stockage froid

Les plateformes numériques modernes sont des aspirateurs à données. Historiques de jeux, logs de connexion, transactions, préférences utilisateurs : tout est stocké. Mais tout n’a pas besoin d’être accessible en une milliseconde. Pourtant, la pratique courante a longtemps été de tout garder sur des disques performants, « au cas où ».

Une politique de gestion du cycle de vie des données (ILM — Information Lifecycle Management) rigoureuse est essentielle pour une infrastructure verte. Les données « chaudes » (utilisées activement) restent sur des SSD rapides mais énergivores. Les données « tièdes » migrent vers des disques capacitifs plus lents. Enfin, les données « froides » (archives légales de plusieurs années) partent sur des bandes magnétiques. Oui, les bandes magnétiques existent encore et elles sont imbattables écologiquement : une fois écrite, la cartouche ne consomme aucune électricité posée sur une étagère.

Cette hiérarchisation permet de réduire considérablement la consommation de stockage. Pour un opérateur de jeux en ligne, qui doit légalement conserver des traces de chaque main jouée pendant des années, le volume se compte en pétaoctets. Stocker cela sur des disques durs rotatifs allumés 24/7 serait un non‑sens écologique et financier.

De plus, la déduplication des données permet d’éviter de stocker plusieurs fois la même information. C’est une technique algorithmique qui repère les motifs répétitifs et ne stocke qu’une seule instance, remplaçant les autres par des pointeurs. Sur des sauvegardes de bases de données, les taux de réduction peuvent atteindre 90 %. C’est 90 % de matériel en moins à alimenter et à refroidir.

Intelligence artificielle et prédiction de charge

L’utilisation de l’intelligence artificielle pour piloter les infrastructures est le dernier maillon de la chaîne d’efficacité. Les systèmes prédictifs analysent les modèles de trafic historiques pour anticiper les besoins. Si l’IA sait que le trafic va augmenter le vendredi soir à 20 h, elle peut pré‑activer des serveurs juste à temps, au lieu de les laisser tourner à vide tout l’après‑midi « par précaution ».

Dans le refroidissement aussi, l’IA fait des merveilles. Google a démontré il y a quelques années qu’une IA pilotant les systèmes de refroidissement pouvait réduire la facture énergétique de 40 % simplement en ajustant les vannes et les ventilateurs en temps réel, bien mieux qu’un opérateur humain ne pourrait jamais le faire. L’algorithme apprend continuellement de la relation entre la charge IT, la météo extérieure et la température interne.

Pour l’utilisateur final qui s’amuse sur sa tablette, tout cela est invisible. Mais cette fluidité, cette absence de coupure, c’est le résultat d’une orchestration complexe où des algorithmes décident en permanence d’allouer ou de libérer des ressources physiques. L’IA permet d’ajuster l’offre d’infrastructure à la demande de service avec une granularité fine, évitant le surprovisionnement chronique qui a longtemps été la norme dans l’industrie.

Même la détection de fraude, cruciale dans le jeu en ligne, bénéficie de ces optimisations. Les modèles tournent sur des unités de traitement tensoriel (TPU) spécialisées, bien plus efficaces par opération que des CPU généralistes. L’infrastructure s’adapte en temps réel aux menaces sans exploser son budget carbone.

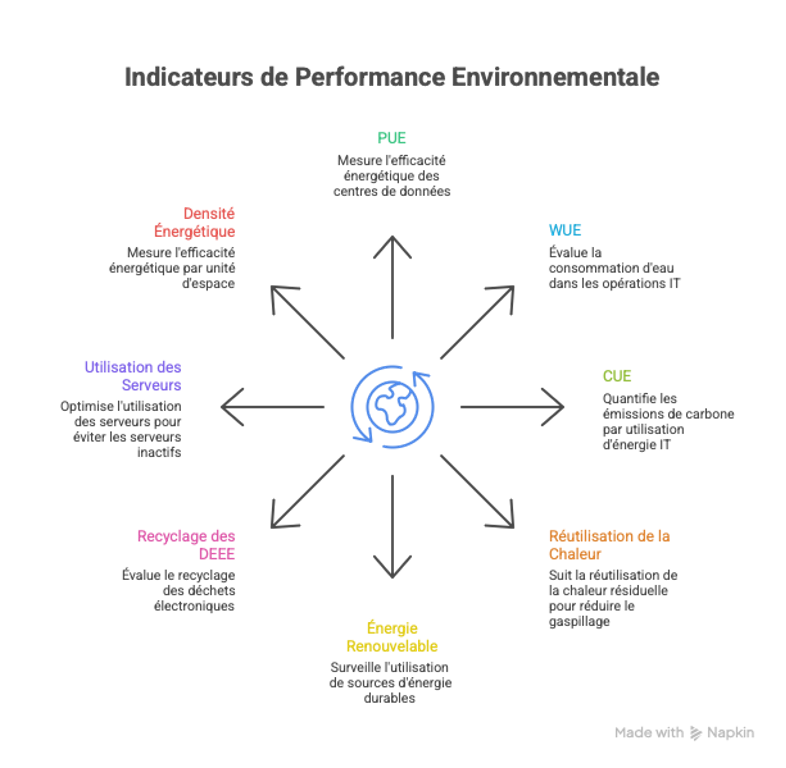

L’importance des certifications et de la transparence

Il ne suffit plus de dire qu’on est vert, il faut le prouver. Les certifications comme ISO 14001 ou ISO 50001 (management de l’énergie) deviennent des standards requis par les partenaires et parfois même par les régulateurs. Les centres de données qui hébergent ces plateformes doivent montrer patte blanche. Utiliser des crédits carbone ou des certificats d’origine (Garanties d’Origine) pour affirmer que l’électricité consommée est verte est une première étape, mais l’efficacité intriguera toujours plus les experts que la compensation.

La transparence est aussi un vecteur de confiance. Publier son PUE en temps réel, détailler sa consommation d’eau (le WUE — Water Usage Effectiveness, souvent négligé mais critique), c’est faire preuve de maturité. Les acteurs du numérique qui cachent ces données sont souvent ceux qui ont les pires performances. À l’inverse, ceux qui investissent massivement dans le durable en font un argument commercial fort.

Liste des indicateurs clés de performance environnementale (KPI) à surveiller :

- PUE (Power Usage Effectiveness) : ratio énergie totale / énergie IT.

- WUE (Water Usage Effectiveness) : litres d’eau consommés par kWh.

- CUE (Carbon Usage Effectiveness) : émissions de CO₂ par kWh IT.

- Taux de réutilisation de la chaleur fatale.

- Pourcentage d’énergie renouvelable dans le mix énergétique.

- Taux de recyclage des déchets électroniques (DEEE) en fin de vie.

- Utilisation moyenne des serveurs (pour éviter les serveurs « zombies »).

- Densité énergétique par rack.

Vers une infrastructure numérique responsable

Il faut se rendre à l’évidence : le numérique immatériel est une illusion. Tout ce qui se passe sur un écran a une existence physique, lourde, faite de cuivre, de silicium, d’eau et d’électricité. Lier le monde du data center industriel à celui du divertissement en ligne permet de comprendre l’échelle des défis à relever. L’approche holistique, qui prend en compte le bâtiment, le matériel, le logiciel et l’usage, est la seule viable à long terme.

Les technologies continuent d’évoluer. Les piles à combustible à hydrogène pour remplacer les générateurs diesel de secours, le stockage d’énergie sur batteries lithium‑ion ou sodium pour lisser les pics, l’informatique quantique qui pourrait (peut‑être) révolutionner certains types de calculs : l’avenir est un chantier permanent. Mais la direction est claire : faire plus avec moins.

En fin de compte, que l’on optimise un serveur pour une banque, un hôpital ou un site de jeux, les lois de la thermodynamique restent les mêmes. La différence réside dans la capacité d’adaptation aux usages spécifiques. En intégrant les principes de durabilité dès la conception de l’infrastructure, on crée des systèmes résilients, performants et économiquement sensés.

L’expert technique d’aujourd’hui doit avoir une vision à 360 degrés. Il ne suffit plus de savoir configurer un pare‑feu ou de monter un rack. Il faut comprendre les flux d’énergie, les impacts thermiques et les enjeux environnementaux globaux. C’est cette convergence de compétences qui permettra de construire le web de demain, un web où la performance ne se fait pas au détriment de la planète.